Há dois anos, a Apple anunciou uma série de novos recursos de segurança infantil, incluindo um sistema que usaria o processamento no dispositivo para procurar materiais de abuso sexual infantil. Apesar da implementação do recurso com foco na privacidade, a Apple enfrentou reações adversas suficientes para o recurso e acabou abandonando seus planos.

Agora, a Apple encontra-se na posição de enfrentar uma pressão renovada de grupos de defesa e investidores ativistas para tomar melhores medidas contra o CSAM.

Como primeiro Reportado por Com fioa segurança infantil o grupo de defesa Heat Initiative está lançando uma campanha multimilionária na qual pressiona a Apple sobre esse assunto. Reportamos esta manhã sobre a resposta da Apple à campanha da Heat Initiative, na qual a empresa reconheceu o precedente potencial de implementação do recurso de detecção de CSAM.

“A varredura de um tipo de conteúdo, por exemplo, abre a porta para vigilância em massa e pode criar o desejo de pesquisar outros sistemas de mensagens criptografadas em vários tipos de conteúdo”, disse Erik Neuenschwander, diretor de privacidade do usuário e segurança infantil da Apple, em entrevista ao Com fio.

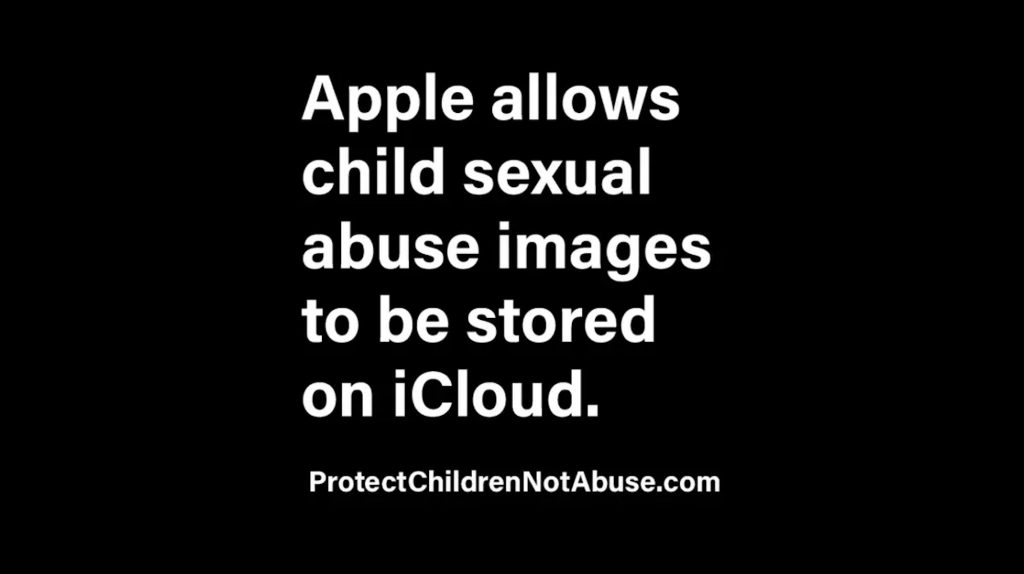

Agora, a campanha completa da Heat Initiative foi lançada oficialmente. No site da campanha, a Heat Initiative assume uma postura agressiva contra a Apple. A campanha inclui linguagem como: “O material de abuso sexual infantil é armazenado no iCloud. A Apple permite isso.”

A campanha explica:

O anúncio histórico da Apple para detectar imagens e vídeos de abuso sexual infantil em 2021 foi silenciosamente revertido, impactando a vida de crianças em todo o mundo. A cada dia que passa, há crianças que sofrem por causa desta inação, e é por isso que apelamos à Apple para que cumpra o seu compromisso.

O grupo de defesa afirma que está pedindo à Apple que “detecte, denuncie e remova imagens e vídeos de abuso sexual infantil do iCloud”. Ele também deseja que a empresa “crie um mecanismo robusto de denúncia para que os usuários denunciem imagens e vídeos de abuso sexual infantil à Apple”.

O site da campanha também inclui vários “estudos de caso” que detalham graficamente casos em que o iCloud foi usado para armazenar fotos e vídeos de abuso sexual. O site também inclui um botão para “Enviar e-mail diretamente para a liderança da Apple”. Este botão abre um formulário de e-mail para um e-mail em massa enviado a toda a equipe executiva da Apple.

A Heat Initiative também enviou uma carta endereçada a Tim Cook na qual o grupo afirma que a inação da Apple coloca “crianças em perigo”.

Em nossa pesquisa recente, encontramos centenas de casos de abuso sexual infantil que foram documentados e divulgados especificamente em dispositivos Apple e armazenados no iCloud. Se a Apple tivesse detectado essas imagens e vídeos, muitas dessas crianças teriam sido retiradas de situações abusivas muito mais cedo.

É por isso que no dia em que você decidir começar a detectar esses conteúdos nocivos, as crianças serão identificadas e não terão mais que suportar abusos sexuais. A espera continua a colocar as crianças em perigo e impede a cura dos sobreviventes, ou daqueles com experiência vivida.

Pressão dos acionistas

Mas, além da pressão da publicidade iminente da Heat Initiative, a Apple também enfrentará em breve pressão dos investidores sobre este assunto. 9to5Mac soube que a Christian Brothers Investment Services está planejando apresentar uma resolução de acionistas que instaria a empresa a tomar medidas para melhorar a detecção de CSAM.

A Christian Brothers Investment Services se descreve como uma “empresa católica de gestão de investimentos socialmente responsável”. Acredita-se que a proposta também desempenhe um papel na campanha publicitária da Heat Initiative. Simultaneamente, o New York Times também informa agora que a Degroof Petercam, uma empresa de investimento belga, também apoiará a resolução.

Como explicamos no passado, isso coloca a Apple entre uma rocha e uma posição difícil. Os defensores da privacidade veem a implementação inicial da detecção de CSAM pela empresa como um precedente perigoso. Enquanto isso, os defensores da segurança infantil dizem que a empresa não está fazendo o suficiente.

Embora a Apple tenha abandonado seus planos de detectar imagens CSAM conhecidas quando armazenadas no iCloud, a empresa implementou uma série de outros recursos de segurança infantil.

Siga a oportunidade: Tópicos, Twitter, Instagrame Mastodonte. Doar para apoiar o Hospital de Pesquisa Infantil St..